Росія є країною-лідеркою з поширення фейкових відео та повідомлень за допомогою штучного інтелекту (ШІ), кажуть дослідники дезінформації.

Попри недосконалість, системи ШІ дозволяють пропагандистській машині Кремля доносити неправду до великої кількості глядачів і читачів швидко і дешево.

"Інформаційним обʼєктом" таких російський фейків і вкидів дослідники називають мешканців США, які щоденно стикаються з потоком фейкових новин, часто не здогадуючись, що більша їх частина продукується саме в Росії.

Водночас американські, і українські експерти поступово освоюють системи ШІ, аби викривати російські фейки.

Як ШІ допомагає читати російський "новояз" англійською

Україна на державному рівні поки лише вивчає можливості штучного інтелекту для боротьби з російськими фейками, повідомили Голосу Америки в урядовому Центрі стратегічних комунікацій та інформаційної безпеки.

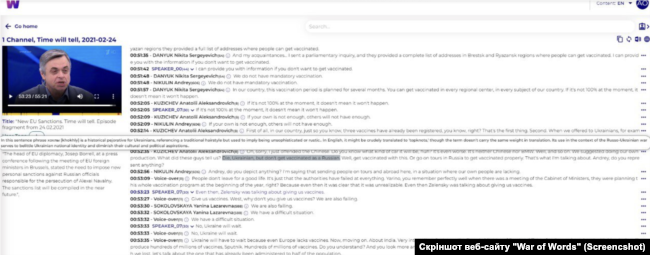

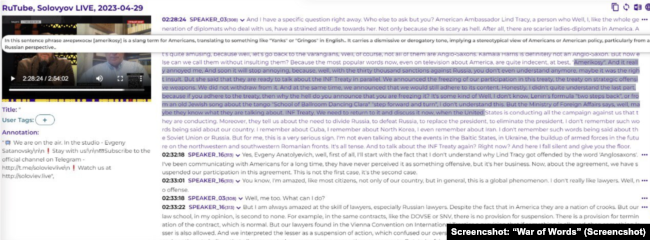

Водночас, з'являються окремі ініціативи. Так, у червні українські розробники презентували онлайн-сховище пропаганди "War of Words", у якому - колекція програм російського телебачення, RuTube, і частково Telegram за минулі 12 років.

У відкритому доступі користувачі інтернету можуть знайти понад 100 тисяч годин пропагандистського відео із транскрипцією російською та англійською мовами. Створювали такий архів із залученням ШІ.

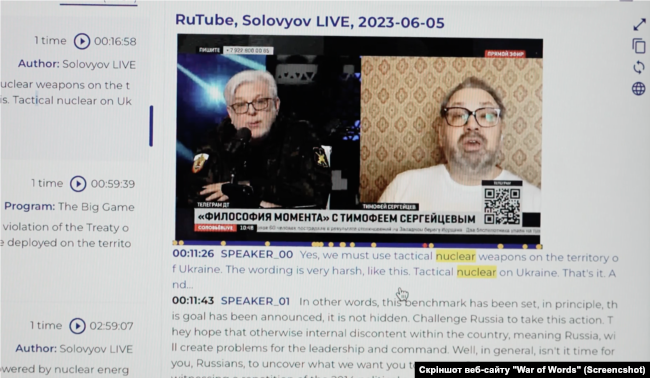

"Цей інструмент дозволяє будь-якій людині англійською мовою отримати доступ до інформації про те, як Росія загрожує всьому західному світу: всі ці погрози розбомбити ядерною зброєю, знайти місця "ухвалення рішень" тощо," - розповідає керівник проєкту, медійник, міністр культури, молоді та спорту України у 2019-2020 рр. Володимир Бородянський.

Бородянський каже, що переклад намагалися адаптувати таким чином, аби англомовні глядачі розуміли контекст і змогли побачити "російський новояз, згідно з яким мир - це війна, не вибухи, а хлопки, не відступ, а жест доброї волі."

З допомогою системи пошуку можна знайти всі програми за темою, наприклад, ядерної зброї. Або всі ефіри, в яких українців називають "хохлами."

Слова, які складно зрозуміти людям, які не володіють російською мовою, зокрема образи на адресу американців, ШІ допоміг перекладати з поясненнями.

"Ми робили це з допомогою ШІ, не перекладаючи все формальною мовою, а з використанням зворотів, які підкреслюють емоційний стан у студії російського телебачення", - пояснює технічний директор проєкту "War of Words" Андрій Орнатський.

Наприклад, часто вживані росіянами слова на адресу американців - такі як "піндос", або "америкос" - містять в англомовному перекладі примітку із англомовним тлумаченням: "це жаргонний термін, яким називають американців, що перекладається на кшталт "янкі" чи "грінго" і має зневажливий принизливий тон".

"Це дозволяє будь-якому носію англійської мови зрозуміти, з яким ставленням і з якою агресією це розповідають на каналах Росії," - пояснив Орнатський.

"Тут був задіяний штучний інтелект для того, щоб максимально наблизити переклад до першоджерела", - каже Бородянський.

Також система дає можливість дослідити, як активно і коли росіяни починали вживати певні наративи, що, кажуть вони, відбувається за командою.

"Можна спіймати той час, коли вони почали вживати слово"хлопки" замість вибухів, і робити "від'ємний наступ", як вони кажуть, або "жест доброї волі". І це дуже цікаво - незалежно від того, з яких каналів вони це кажуть,... вони починають казати однакові речі завжди одночасно - година в годину", - розповів Орнатський.

Володимир Бородянський сподівається, що український інструмент дозволить дослідникам, зокрема західним, краще вивчити російську пропаганду, яку він називає феноменом 21 століття:

"Коли сім'я - частина тут (в Україні, - ред.), а частина родичів в Росії, і вони кажуть: "ні-ні, ви не розумієте, все нормально, ми вас звільняємо," - в багатьох людей було прозріння: а як насправді працює ця пропаганда? Що таке можна сказати брату, сестрі, матері, доньці, аби вона більше вірила російській пропаганді, ніж своїм рідним в Україні?"

За словами Бородянського, особливо важливо, що англомовна аудиторія разом із текстом бачить відео з емоціями російських ефірів, адже саме відео у пропаганді відіграє ключову роль:

"Ми знаємо про те, що серед людей, які дивляться телебачення (російське - ред.), війну підтримують 80%. Серед людей, які не дивляться телебачення, - війну підтримуєють 40%. Це їхні цифри, російського дослідження".

Допомога ШІ з викриття брехні про "смертоносні лабораторії" Pfizer та замах на Карлсона

Використання ШІ для протидії пропаганді зараз перебуває на початковому етапі і у США, розповідає аналітик із дезінформації у соцмережах, доцент Клемсонського дослідницького університету в Південній Кароліні Деррен Лінвілл.

Це парадокс, каже він, адже сама Росія потужно використовує ШІ для поширення брехні в соцмережах, які створені саме американськими компаніями:

Соцмедійні платформи створюють переважно американські компанії... а потім ними користуються зловмисники, переважно росіяни

"Самі соцмедійні платформи створюються на Заході, їх створюють і запускають переважно американські компанії. А потім цими технологіями користуються зловмисники, переважно росіяни - із власними цілями і без особливого контролю з боку компаній, які впроваджують ці технології," - каже Лінвілл.

Наразі група дослідників університету Клемсона освоює можливості того, як використовувати ШІ для виявлення фейків і пропаганди, які раніше були створені також штучним інтелектом:

"Штучний інтелект - це інструмент, за допомогою якого можна спробувати відокремити голку від копиці сіна, щоб розбити певні речі за категоріями, які потім можна спробувати зрозуміти", - пояснює аналітик.

Так можливості ШІ допомогли аналітикам з університету Клемсона досліджувати російський слід в низці історій. Зокрема - про "замах" на американського телеведучого Такера Карлсона.

"Кілька місяців тому журналіст Такер Карлсон відвідав Москву, взяв інтерв’ю в Путіна і зайшов у продуктовий магазин, невтомно розповідаючи про те, як там усе чудово. Й одразу після того з'явилася історія, що Україна намагалася вбити Такера Карлсона. Ця історія була повністю сфарбиркована росіянами", - каже Лінвілл.

Він пояснює, що з допомогою ШІ вдалося виявити, що цей фейк спочатку з’явився на трьох окремих веб-сайтах, кожен з яких пов'язаний з Росією, і кожен з яких був створений з допогою ШІ.

"Наприклад, якщо я хочу подивитися на розмови про замах на Такера Карлсона, якого насправді ніколи не було, ШІ може допомогти мені зрозуміти: якими способами люди про це говорять, які різні слова вживають, щоб це описати, які зображення чи відео використовують для цих розмов", - пояснив дослідник.

Голос Америки також встановив неправдивість новини про нібито замах на життя Карлсона у Москві, до якого, як стверджувалося, начебто були причетні українські спецслужби.

"Ця історія, звісно, повністю вигадана російськими зловмисниками, які використали ці веб-сайти (згенеровані ШІ та повязані з РФ, - ред.) для подальшого поширення її в соцмережах. Спочатку вона була опублікована на веб-сайті під назвою The Chicago Chronicle, який після цього закрили", - пояснює Лінвілл.

За словами дослідника, ШІ допомагає російським пропагандистам підтримувати й наповнювати інформацією низку онлайн-ресурсів, замаскованих під американські веб-сайти.

"Вони створюють сайти, такі як DC weekly.com або з назвою інших американських міст, і використовують ШІ, щоб красти історії з інших сайтів, регулярно оновлювати вміст і робити так, щоб ці веб-сайти виглядали як справжні сторінки новин", - пояснює Лінвілл.

"Якщо змонтувати маніпулятивно, можна зробити Байдена схожим на старого, що похитується"

Оскільки загроза дезінформації набула величезних масштабів, у США зʼявилися приватні компанії, що створюють програми на основі ШІ, які допомагають викривати фейки.

"З допомогою нашого інструменту ви можете взяти частину контенту, чи, наприклад, 10 тис. одиниць контенту, пропустити їх через систему, і вона видасть показник упевненості щодо того, чи це може бути діпфейком або дезінформацією. Зазвичай усе, на що система видає показник у понад 50%, справді демонструє ознаки маніпуляції", - розповідає співзасновниця компанії "Deep Media AI" Емма Браун.

За її словами, такими інструментами на основі ШІ користуються як органи влади, так і компанії-власники соцмереж.

"Наші інструменти дозволяють, наприклад, компаніям-власникам соцмереж не лише визначати, що правдиве, а що фейкове, але й знати, що може бути шкідливою інформацією, і допомагати виявляти це на початковому етапі, щоб користувачі залишалися в безпеці", - каже Браун.

При цьому вона визнає, що регулювання щодо неправдивої інформації, особливо в соцмережах, знаходиться на недостатньому рівні:

Ми все ще перебуваємо на початковому етапі регуляції фейкового контенту

"Ми все ще перебуваємо на початковому етапі регулювання щодо фейкового контенту. Це одна з найбільших проблем нашого часу. Але ми бачимо величезну цікавість до цієї проблеми в людей, із якими спілкуємося... Я дуже рада бачити, що люди приймають цей виклик."

Головним викликом Браун називає саме підробні відео, створені з допомогою ШІ:

"У 2020 р. це не було тим, що могла б створити пересічна людина. Лише кілька людей знали, як створювати діпфейки. А тепер люди можуть створювати їх на власних телефонах, і це - виклик та величезний фактор ризику", - каже вона.

За словами Лінвілла, дешеві підробні відео можуть бути такими ж ефективними, як і складніші діпфейки, які важко ідентифікувати:

"Ми зараз бачимо це в американській політиці. Наприклад, вони можуть узяти відео президента Байдена, де він, можливо, трохи блукає. Але якщо змонтувати маніпулятивно, можна зробити його схожим на старого, що похитується..."

Фейк, який "видали" краватки

Попри намагання дослідників ефективніше застосовувати ШІ для боротьби із російською пропагандою, вони кажуть, що пересічні споживачі інформації можуть і самі розпізнати багато фейків.

Експерти з досліджень дезінформації наголошують, що штучний інтелект не ідеальний, і радять звертати увагу на деталі: фейкові фото й відео часто видають невідповідні руки, одяг, прикраси чи міміка.

Так сталося у випадку із фейковим відео із заявою речника Державного департаменту США Метью Міллера.

На початку червня російські телеграм-канали поширили відео з нібито його словами про те, що в Бєлгороді немає цивільних осіб, а відтак США вважають місто законною ціллю для українських ударів.

При цьому на початку відео речник має краватку синього кольору, а після запитання журналіста вона змінюється на рожево-червону.

Як зазначило видання The New York Times, фейк з'явився через день після того, як офіційні особи США заявили, що Україна може використовувати американську зброю для обмежених ударів по Росії.

"Чи це були змонтовані кліпи з моїх слів, де я говорю одне слово, а їх змонтували різними способами, чи це версія ШІ, - ми ще не знаємо. Ми це вивчаємо," - так Метью Міллер особисто прокоментував цей відеофейк на брифінгу 5 червня.

Водночас він жартома застеріг глядачів та журналістів бути пильними до відео, в яких він фігурує:

"Якщо ви бачите відео зі мною, і колір моєї краватки та сорочки змінюється від моменту, коли мені ставлять запитання, до моменту, коли я даю відповідь, це, очевидний показник, що відео несправжнє".

Тим часом журналісти The New York Times зазначили, що попри помітні ознаки маніпуляцій, 49-секундний відеоролик із Міллером ілюструє "зростаючу загрозу дезінформації та особливо діпфейкових відео, створених за допомогою ШІ".